下面是一份 《Introduction to Agents》全篇中文直译 (含目录、致谢、图表标题与脚注),并保留关键专业术语英文原文(如 Agent Ops, RAG, Orchestration Layer, ADK, MCP, A2A, HITL, OpenTelemetry 等)以便核对与检索。若原文为品牌名、专有名词或协议名称,均以英文保留或中英并列。为便于参考,我在各主要章节处附上来源标记,并在需要处指明原文页码与图号。

封面(第 1 页)

Introduction to Agents(智能体白皮书)

作者:Alan Blount, Antonio Gulli, Shubham Saboo, Michael Zimmermann, Vladimir Vuskovic

前言与致谢(第 2 页)

Acknowledgements(致谢)

内容贡献者(Content contributors):Enrique Chan, Mike Clark, Derek Egan, Anant Nawalgaria, Kanchana Patlolla, Julia Wiesinger

策展与编辑(Curators and editors):Anant Nawalgaria, Kanchana Patlolla

设计(Designer):Michael Lanning

目录(第 3–5 页)

- From Predictive AI to Autonomous Agents(从预测式 AI 到自主智能体)

- Introduction to AI Agents(AI 智能体简介)

- The Agentic Problem-Solving Process(智能体问题求解流程)

- A Taxonomy of Agentic Systems(智能体系统分类法)

- Level 0: The Core Reasoning System(核心推理系统)

- Level 1: The Connected Problem-Solver(连接式问题求解者)

- Level 2: The Strategic Problem-Solver(战略型问题求解者)

- Level 3: The Collaborative Multi-Agent System(协作式多智能体系统)

- Level 4: The Self-Evolving System(自演化系统)

- Core Agent Architecture: Model, Tools, and Orchestration(核心架构:模型、工具与编排)

- Model: The “Brain” of your AI Agent(模型:智能体的“大脑”)

- Tools: The “Hands” of your AI Agent(工具:智能体的“手”)

- Retrieving Information: Grounding in Reality(信息检索与现实对齐)

- Executing Actions: Changing the World(执行行动:改变世界)

- Function Calling: Connecting Tools to your Agent(函数调用:连接工具与智能体)

- The Orchestration Layer(编排层)

- Core Design Choices(核心设计抉择)

- Instruct with Domain Knowledge and Persona(以领域知识与人格进行约束/指令)

- Augment with Context(用上下文增强)

- Multi-Agent Systems and Design Patterns(多智能体系统与设计模式)

- Agent Deployment and Services(部署与服务)

- Agent Ops: A Structured Approach to the Unpredictable(Agent 运维:结构化应对不确定性)

- Measure What Matters: Instrumenting Success Like an A/B Experiment(衡量要紧之处)

- Quality Instead of Pass/Fail: Using a LM Judge(用 LM 评审衡量质量)

- Metrics-Driven Development: Your Go/No-Go for Deployment(指标驱动的上线决策)

- Debug with OpenTelemetry Traces: Answering “Why?”(用 OpenTelemetry Trace 调试)

- Cherish Human Feedback: Guiding Your Automation(重视人类反馈)

- Agent Interoperability(互操作性)

- Agents and Humans(人与智能体)

- Agents and Agents(智能体与智能体)

- Agents and Money(智能体与金钱)

- Securing a Single Agent: The Trust Trade-Off(单体安全:信任的权衡)

- Agent Identity: A New Class of Principal(智能体身份)

- Policies to Constrain Access(约束性策略)

- Securing an ADK Agent(保护 ADK 智能体)

- Scaling Up from a Single Agent to an Enterprise Fleet(从单体到企业集群)

- Security and Privacy(安全与隐私)

- Agent Governance(治理与控制平面)

- Cost and Reliability(成本与可靠性)

- How agents evolve and learn(智能体如何演进与学习)

- Simulation and Agent Gym(仿真与 Agent Gym)

- Examples of advanced agents(高级示例)

- Google Co-Scientist

- AlphaEvolve Agent

- Conclusion(结论)

- Endnotes(注释/参考)

从预测式 AI 到自主智能体(第 6–7 页)

多年来,AI 的重点在于执行被动、离散任务:回答问题、翻译文本、依据 prompt 生成图像。这一范式虽强大,却在每一步都需要人工指令。我们正经历一次转变:从“只会预测/生成内容”的 AI,走向能够**自主地解决问题与执行任务(autonomous problem‑solving and task execution)**的新型软件。

智能体(Agent)并非只是在静态工作流中的 AI 模型,而是一个完整应用:它会制定计划并采取行动以达成目标。它把语言模型(LM)的推理能力与实际行动能力(工具/函数/API)结合,使其能处理模型本身无法独立完成的复杂多步任务;关键能力在于无需人在每一步指引也能自行判断下一步。

本文件是五部分系列中的第一部分,为从 PoC 走向生产级 agentic 系统的开发者、架构师与产品负责人提供正式指南。它的重点包括核心剖析(Model/Tools/Orchestration)、能力分级(从连接式求解到多智能体协作)、架构设计与生产化(Agent Ops),以帮助构建、部署与治理能“reason–act–observe”以达成目标的新一代智能应用。

AI 智能体简介(第 8–10 页)

我们常以拟人化词语描述人机交互(如 think, reason, know),但“语义上的知道”与“为最大化奖励而高概率输出”是不同概念——尽管 99.X% 的时候结果相同。

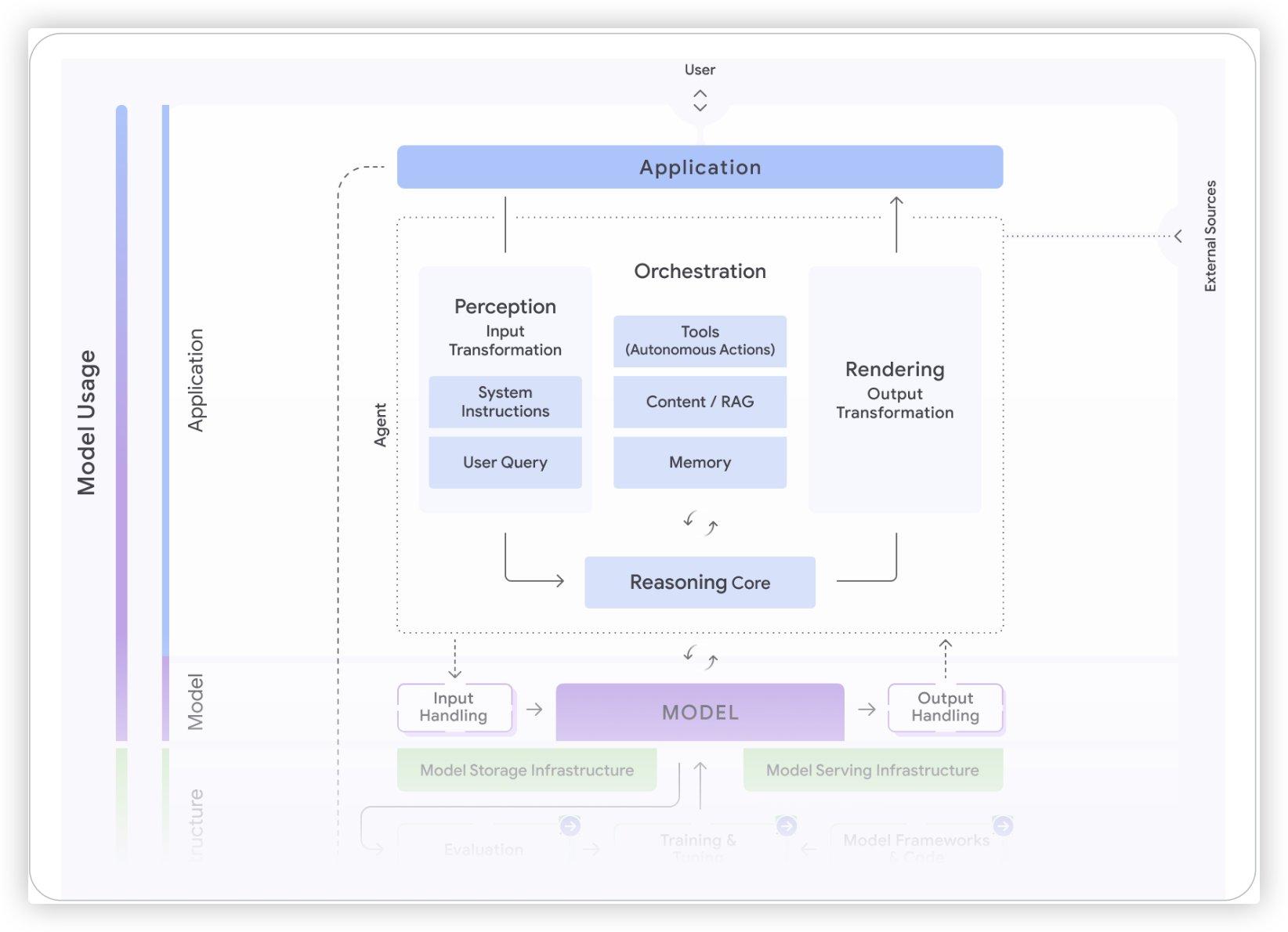

最简定义:AI Agent 是由模型(Model)、工具(Tools)、编排层(Orchestration Layer)与运行时服务(Runtime Services)组成的系统,借助LM‑in‑the‑loop来完成目标。

- Model(“大脑”):LM/基础模型作为推理引擎,处理信息、评估选项并做出决定。Agent 成为 LM **输入上下文(context window)**的终极策展人。

- Tools(“双手”):API、代码函数与数据存取(数据库、向量库)连接外部世界。Agent 负责计划使用何种工具、执行工具,并把结果纳入下一次 LM 调用的上下文。

- Orchestration Layer(“神经系统”):负责规划、记忆(state/memory)与推理策略,用 Chain‑of‑Thought 或 ReAct 将复杂目标拆解为步骤,决定何时“思考”与何时“用工具”。也负责给 Agent “记忆”。

- Deployment(“身体与双腿”):生产部署让 Agent 成为可靠、可访问的服务(带监控、日志、管理),通过 UI 或 Agent‑to‑Agent(A2A) API 供人或其他 Agent 调用。

开发范式的转变:传统开发者像“砌砖工”写死每一步;Agent 开发者更像“导演”,负责设置场景(指令与提示)、挑演员(工具与 API)、配上下文(数据),引导这个“演员”交付预期表现。LM 的灵活性也是稳定性难题:要让它“只做一件事”很难,因而需要context engineering(上下文工程)。Agent Ops 以可观测性(traces/logs) 帮助调试与优化。

智能体问题求解流程(第 10–13 页)

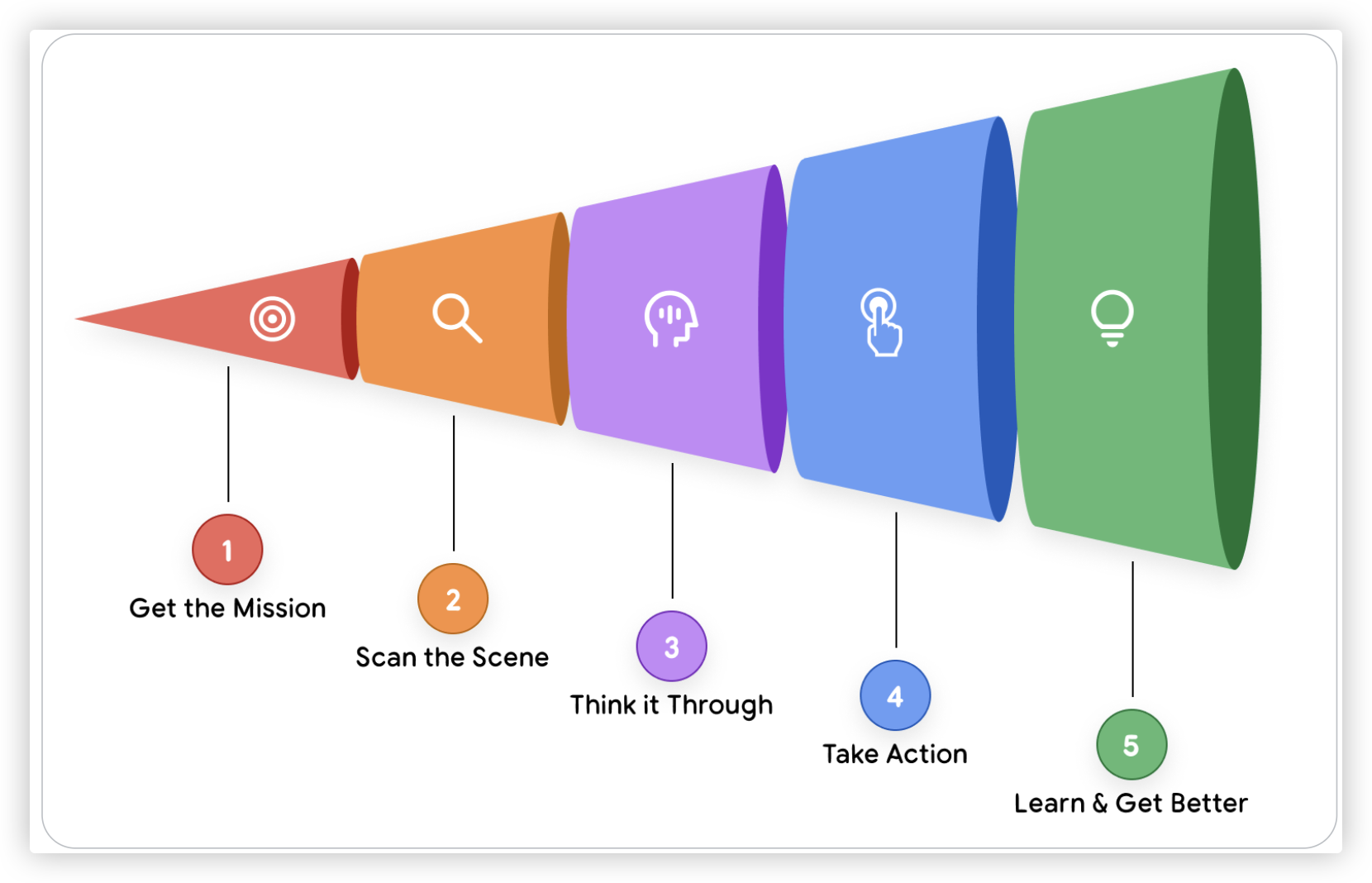

Agent 的核心是一种持续的循环,可概括为五步:

- Get the Mission(获得任务):来自用户或自动触发的高层目标(如“为团队安排大会差旅”)。

- Scan the Scene(扫描场景):编排层收集上下文:请求文本、短期/长期记忆、工具可达的信息等。

- Think It Through(推理规划):模型驱动的思考环节,将任务与场景对齐并制定计划(常为链式推理)。

- Take Action(执行行动):按计划调用工具(API/函数/数据库查询等)。

- Observe and Iterate(观测并迭代):把工具返回加入上下文/记忆,回到思考环节直至完成任务。

图 1(第 12 页) 展示了该“Think–Act–Observe”流程示意。以客服智能体回答“订单 #12345 在哪?”为例:

- 先于“Think”阶段拟定多步计划:识别(查询内部订单)→ 追踪(取快递单号并查外部承运商 API)→ 报告(综合结果答复)。

- 执行 find_order(“12345”) → 观测到包含 tracking number“ZYX987”;

- 执行 get_shipping_status(“ZYX987”) → 观测状态“Out for Delivery”;

- 综合生成答复:“您的订单 #12345 正在派送中(Out for Delivery)”。

智能体系统分类法(第 14–18 页)

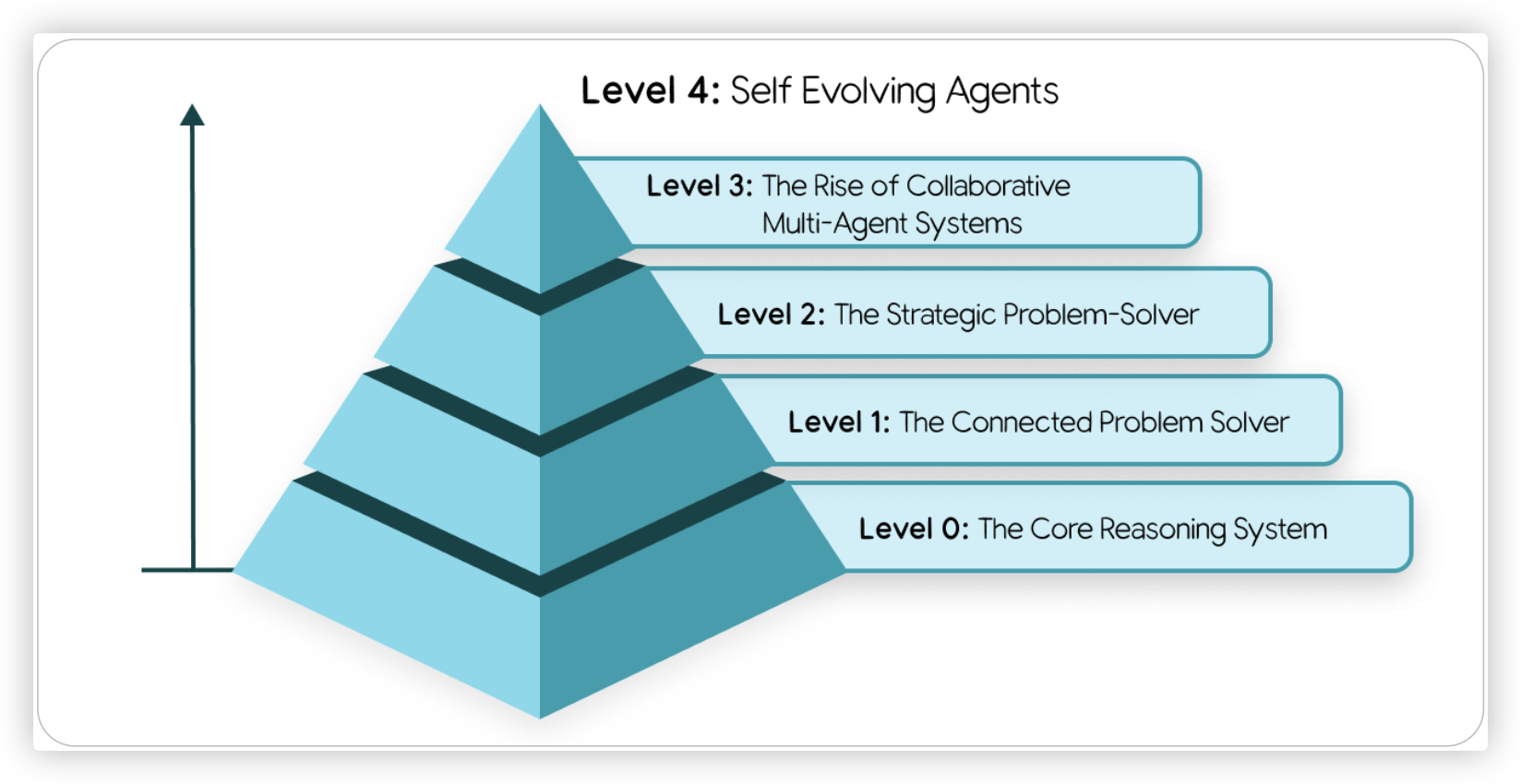

图 2(第 14 页) 给出分级金字塔:

- Level 0:核心推理系统(仅 LM,无工具/记忆/外界交互)。长处是广博训练知识;短板是无实时感知。

- Level 1:连接式问题求解者(连上外部工具)。能通过检索、搜索或 RAG 获取实时事实并作答。

- Level 2:战略型问题求解者(context engineering 成为关键)。能选择/打包/管理每一步所需的最相关信息并规划多步任务。

- Level 3:协作式多智能体系统(一支专家团队协作完成复杂业务流程;Agent 把其他 Agent 当作工具)。

- Level 4:自演化系统(能识别自身能力缺口并自主创建新工具/新智能体来填补)。

核心架构:模型、工具与编排(第 19–22 页)

模型:智能体的“大脑”

选择 LM 关乎推理能力、成本与延迟。不要只看学术基准;应基于业务目标设定评测(如在私有代码库或特定表单上测试),并在质量–速度–价格间权衡。可以采用多模型路由:用强模型(如 Gemini 2.5 Pro)做复杂规划,用快模型(如 Gemini 2.5 Flash)做分类、摘要等高频小任务。多模态可用原生多模态模型,或专用工具(Cloud Vision/Speech‑to‑Text)+ 语言模型的“先转文本再推理”路径。模型更新迅速,需以 Agent Ops + CI/CD 持续评估与迭代。

工具:智能体的“手”

- 信息检索(RAG/NL2SQL):让智能体在发言前“先查再答”,以事实对齐现实、降低幻觉。

- 执行行动(API/代码执行):发送邮件、建日程、改工单;在沙箱中生成与运行代码(SQL/Python)以计算/转换。

- 以人为环(HITL):例如 ask_for_confirmation() / ask_for_date_input(),在关键决策处引入人类。

函数调用(Function Calling)

要可靠地用工具,需清晰契约与安全编排。可用 OpenAPI 描述工具 schema,让模型生成正确参数并解析响应;也可用 Model Context Protocol(MCP) 做便捷发现与连接。部分模型有原生工具(如 Gemini 的原生 Google Search)。

编排层 & 核心设计抉择(第 22–26 页)

编排层(The Orchestration Layer)

相当于“中枢神经系统”,负责驱动 Think–Act–Observe 循环、管理状态机与开发者的规则逻辑,并产出详细 traces/logs用于可观测性与调试。

核心设计抉择

- 自治程度:从确定性工作流 + LM 辅助到LM 驾驶座的高度自适应。

- 实现方式:无代码适合快启;代码优先(如 Google Agent Development Kit, ADK)能获得深度控制与可集成性。

- 框架要求:开放、可插拔(防 vendor lock‑in);精细控制(规则治理 LM 的非确定性);重视可观测性(能追踪提示、工具选择、参数与观测结果)。

指令与人格(Persona)

用系统提示(system prompt)为智能体立“宪法”:角色、语调、输出 schema、约束与何时为何用工具,并附示例。

记忆与上下文增强(Context & Memory)

- 短期记忆:会话历史/状态(动作–观测对)。

- 长期记忆:通常以RAG + 向量库/搜索实现,可查询自身历史与用户偏好以供个性化体验。

多智能体与设计模式

把复杂流程拆分给专精智能体,便于构建/测试/维护。

- Coordinator(协调者)模式:处理动态/非线性任务,由“经理”智能体拆分子任务并路由。

- Sequential(顺序链)模式:线性装配线式输出传递。

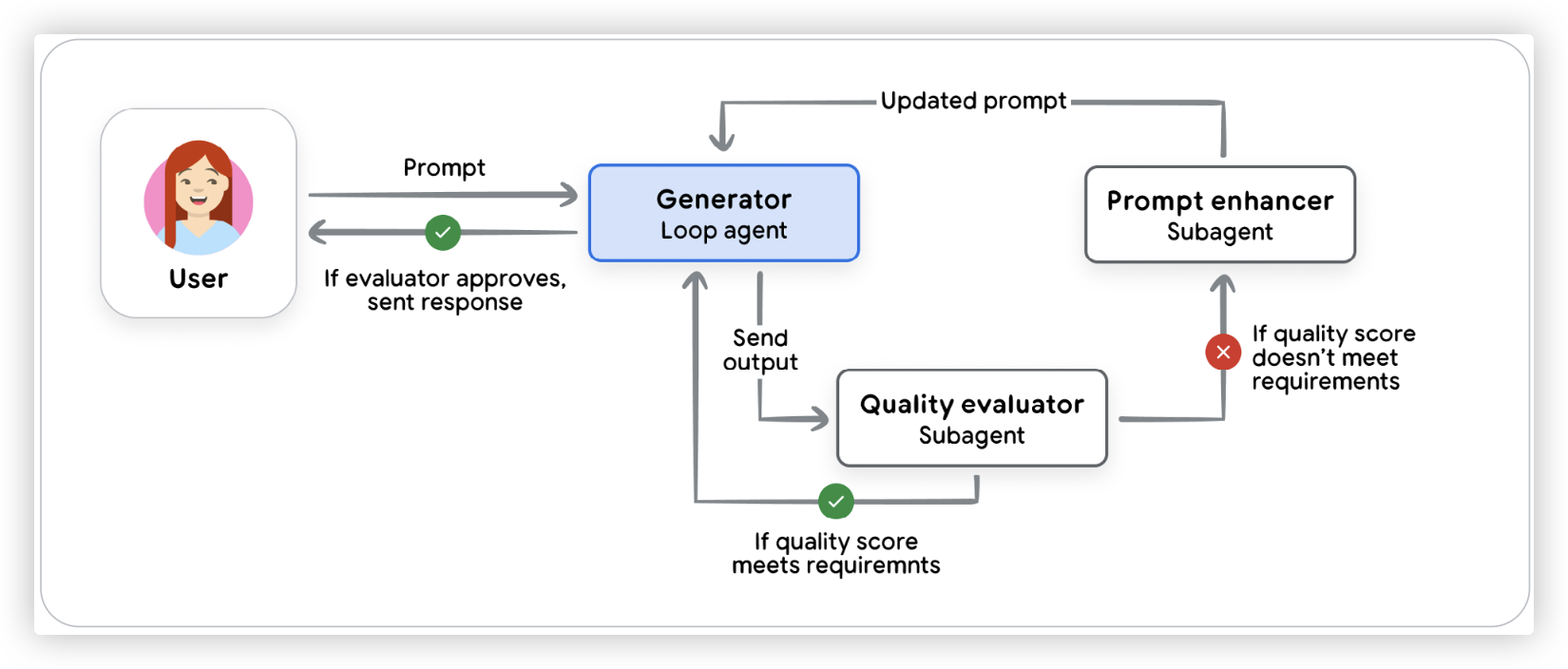

- Iterative Refinement(迭代打磨)模式:生成者与批评者循环优化质量与安全。**图 3(第 25 页)**示意此模式。

- HITL 模式:高风险任务上引入人类审批。

部署与服务(第 26–27 页)

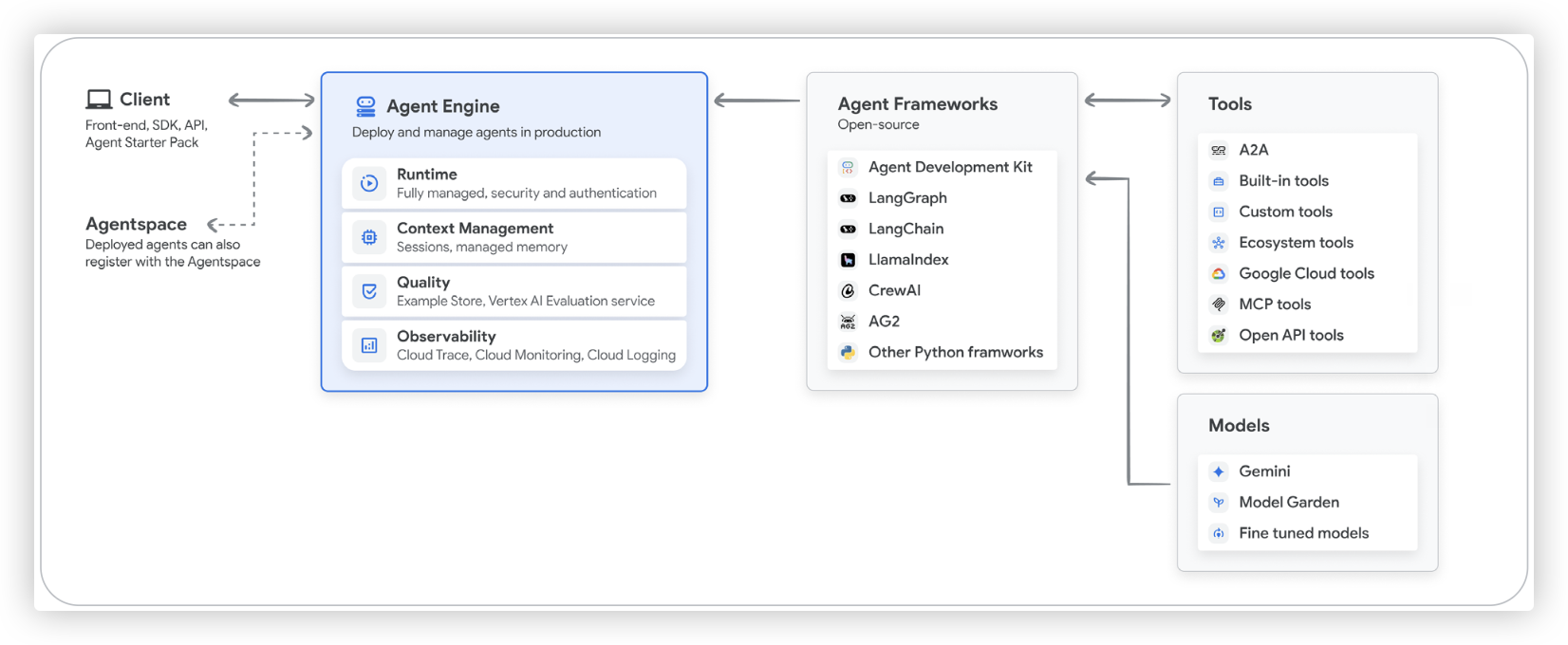

把本地 Agent 部署到常驻服务器,供人和其他 Agent 使用。生产环境需会话/记忆持久化、日志/监控、隐私/合规/数据驻留等。可选:

- Vertex AI Agent Engine 等平台化托管;

- 容器化(Docker)+ Cloud Run/GKE 等标准运行时。 早期探索可使用框架自带的一键部署;走向安全与生产就绪需CI/CD 与自动化测试。**图 4(第 27 页)**展示了 Vertex AI Agent 架构界面。

Agent Ops:结构化应对不确定性(第 27–31 页)

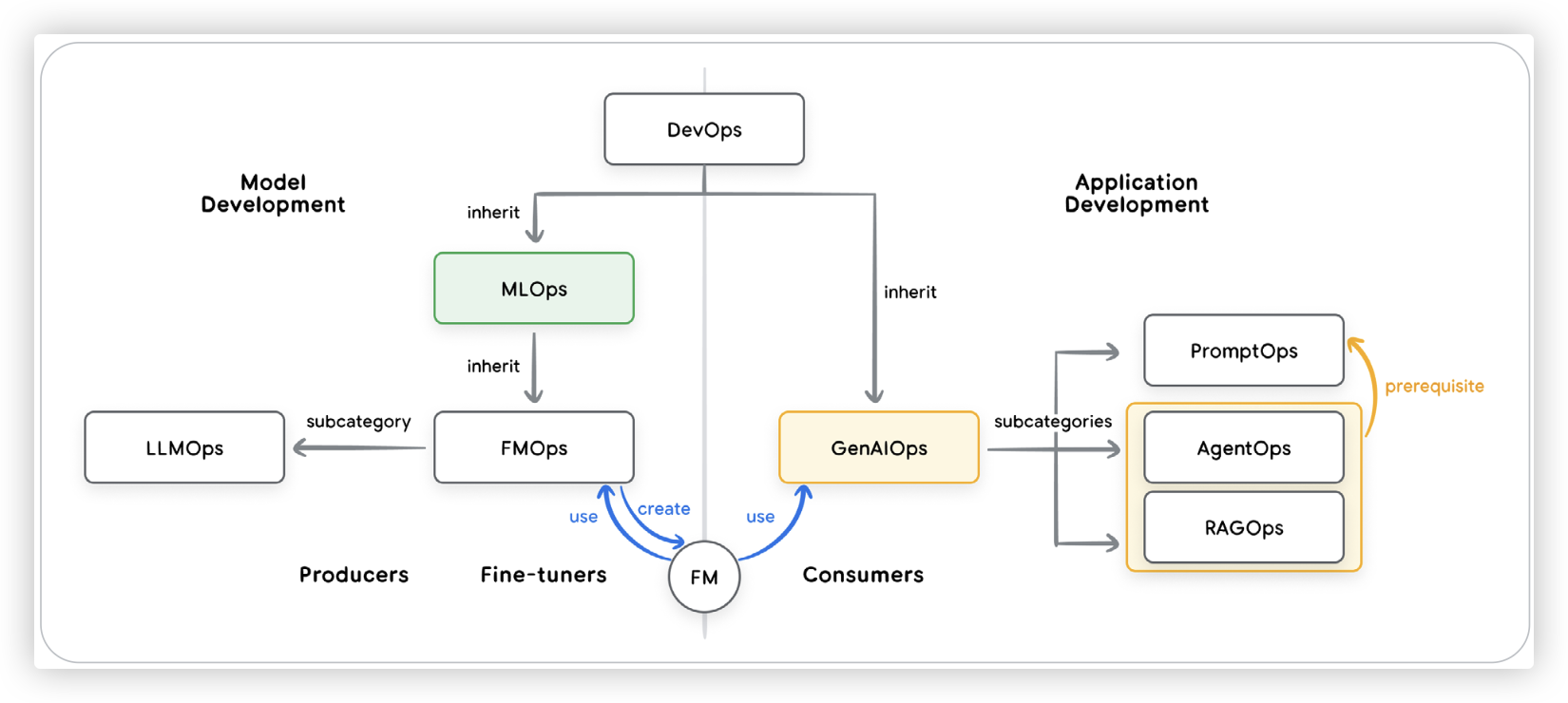

从确定性软件转向随机性智能体,传统单元测试“output == expected”已不适用;语言质量往往需要LM 充当评审(LM as Judge)。**图 5(第 28 页)**展示了 DevOps/MLOps/GenAIOps 的关系。

衡量要紧之处(像 A/B 实验一样设仪表)

定义业务导向 KPI:目标完成率、用户满意度、任务延迟、每交互成本,以及对营收/转化/留存等业务指标的影响,并以此驱动观测与优化。

用 LM 评审衡量质量(而非简单通过/失败)

以预设评分细则(rubric)让强模型评估输出:是否正确、是否有事实依据、是否遵守指令等。基于黄金数据集自动评估,但仍需领域专家复核。

指标驱动的开发与上线

版本改动跑完整评测集,与生产基线对比质量/延迟/成本/成功率等;可用A/B 灰度降低上线风险。

用 OpenTelemetry Trace 回答“为什么?”

当指标下滑或有缺陷上报,需要追因:Trace 记录了完整执行轨迹(提示、内部推理_如可用_、工具选择、参数、原始观测数据)。Trace 适合定位根因,关键信息可转化为指标。

重视人类反馈

用户的“踩”与缺陷报告是最有价值的数据:将其回溯到分析平台形成洞见与告警,并把复现出的场景加入评测集,形成免疫同类错误的机制闭环。

互操作性(第 31–34 页)

人与智能体(Agents and Humans)

最常见是UI 交互:从简易聊天到结构化 JSON驱动的富前端。HITL 包含意图澄清、目标扩展、确认等。

Computer Use 工具让 LM 接管 UI 操作(导航、点击、表单预填等),或借助 MCP UI / AG UI / A2UI 等由工具控制/事件驱动/消息驱动生成 UI 的方式反向改变 UI。

实时多模态(live mode) 让语音双向流式与可打断交互成为可能(如 Gemini Live API),并结合摄像头/麦克风以低延迟产生更自然的人机协作。

智能体与智能体(Agents and Agents)

企业内不同团队将构建不同专精智能体。为解决发现与通信的通用性问题,提出 Agent‑to‑Agent(A2A)协议:

- 通过 Agent Card(数字名片,JSON)发布能力、端点与凭证,便于标准化发现;

- 通信使用任务导向异步模式,支持长连接流式进度,从而支撑 Level 3 的协作式多智能体系统。

智能体与金钱(Agents and Money)

当 Agent 代表用户进行交易/谈判/支付时,需要信任层:

- Agent Payments Protocol(AP2)用加密签名的委托(mandate)建立不可抵赖审计轨迹;

- x402 借助 HTTP 402 Payment Required 实现机器对机器的小额支付(如 API 计次付费)。

单体安全:信任的权衡(第 34–38 页)

为提升实用性必须授予权能(自主决策、执行工具),但权能带来风险(越权操作、敏感信息泄露)。不能只依赖模型判断,需纵深防御(defense‑in‑depth):

- 确定性护栏:模型外的硬规则/策略引擎(如 >$100 的采购需阻断或二次确认)。

- 推理式防御:用小型守卫模型或对抗训练检测风险/违规计划。

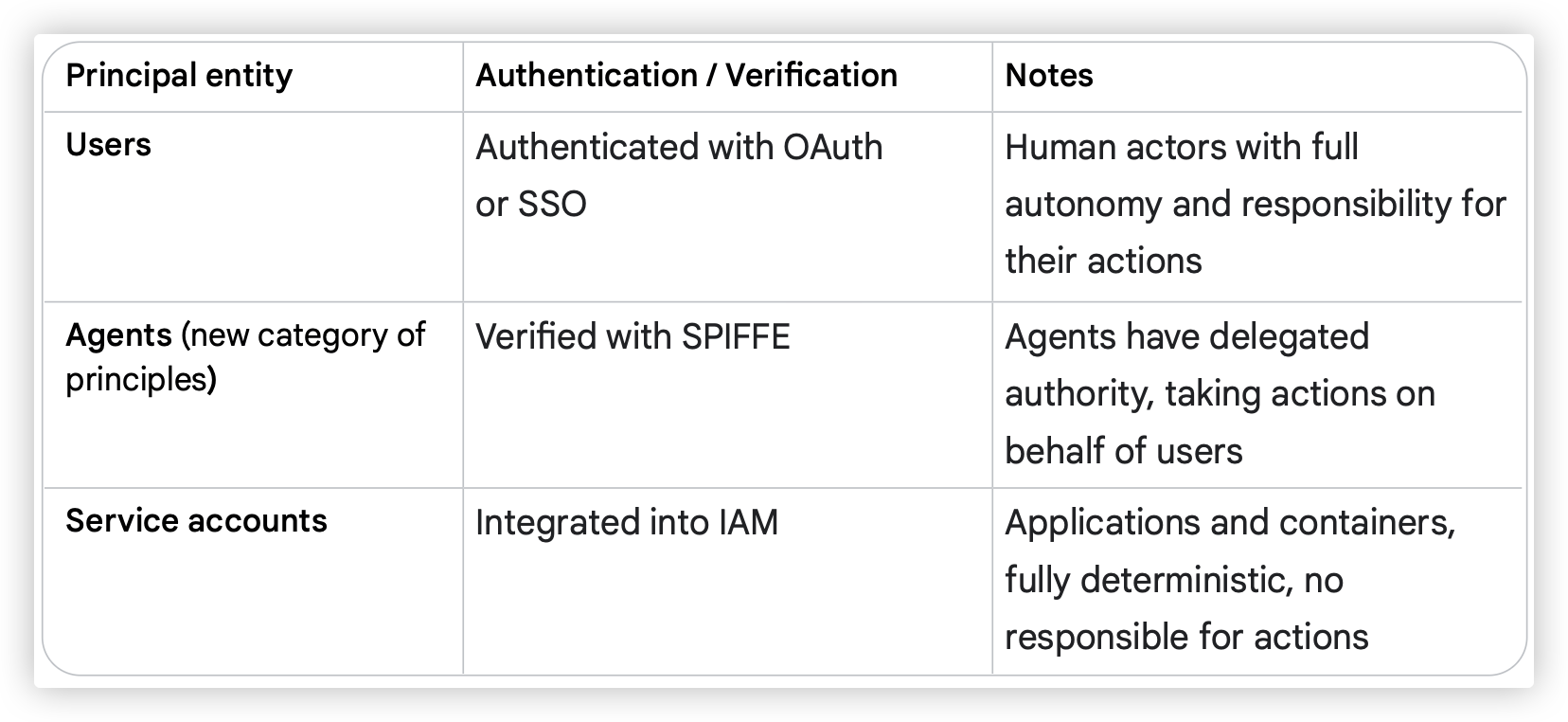

智能体身份(Agent Identity:新的主体类型)

除了用户(OAuth/SSO)与服务账户(IAM),Agent 是第三类主体,需具备可验证身份(如 SPIFFE),以便实施最小权限。不同 Agent 获得精细的读/写授权,限制潜在爆炸半径。文中给出了“主体类别×认证方式×说明”的对照表。

访问约束策略(Policies)

策略属于授权(AuthZ),需对Agent/工具/其他 Agent/可共享上下文/远端 Agent分别施权,以实现最小而相关的权限集合。

保护 ADK 智能体

分清用户账号、服务账号、智能体身份三类认证;在API 治理层定义约束策略;在工具/模型/子 Agent中内建护栏(即使 LM 产生错误计划也会被工具拒绝执行)。

ADK 提供 Callbacks/Plugins:如 before_tool_callback 在执行前校验参数或Gemini‑as‑a‑Judge(用低成本模型筛查注入/有害内容)。企业可选用Model Armor等托管安全层实时筛查注入、越狱、PII、恶意 URL等威胁。

从单体到企业集群(第 39–42 页)

图 6(第 39 页)示意了安全与智能体的总体关系。随着Agent/工具在组织内扩张,会形成复杂的交互网络与数据流,需要更高阶治理与集中式控制平面。

图 6(第 39 页)示意了安全与智能体的总体关系。随着Agent/工具在组织内扩张,会形成复杂的交互网络与数据流,需要更高阶治理与集中式控制平面。

安全与隐私(Hardening the Agentic Frontier)

平台应确保企业私有数据不被用于训练基础模型,并通过 VPC Service Controls 等措施隔离;需要输入/输出过滤作为“提示防火墙”;并提供如知识产权保障等合同层面承诺,以支撑生产部署信心。

Agent 治理:以控制平面取代蔓延(Sprawl)

建立统一网关作为运行时策略执行与集中治理的关口:

- 运行时策略:认证与授权、统一日志/指标/Trace,实现单一视图。

- 集中治理:借助注册中心(企业版应用商店)进行发现/复用/清点/版本化/发布审核与细粒度访问策略。

成本与可靠性(基础设施)

需要既可靠又经济:

- 按需缩扩容/scale‑to‑zero;

- 关键低延时工作负载可用Provisioned Throughput与 Cloud Run 99.9% SLA;

- 全面监控成本与性能,使 Agent 成为企业核心可靠组件。

智能体如何演进与学习(第 42–46 页)

真实世界在变(政策、技术、数据格式),Agent 若不能适应会**“老化”**。人工维护集群成本高,需让 Agent 在岗学习与演进:

- 运行时经验:会话日志、Traces、记忆、HITL 反馈等。

- 外部信号:新政策文件、法规更新、其他智能体的评审等。 优化手段包括:

- 增强型上下文工程:持续优化提示、few‑shot 示例与检索内容。

- 工具优化与创造:识别能力缺口并获得/创建/修改工具(如自动写 Python/SQL)。 还可重构多智能体模式或采用 RLHF 等。

示例(合规新规学习):

- 查询智能体检索数据;报告智能体生成草稿;批评智能体用合规规则审阅,必要时升级到人类专家;学习智能体收集人类纠正并泛化为新规则或上下文。**图 7(第 45 页)**给出多智能体工作流示意。

仿真与 Agent Gym:下一前沿(第 46 页)

前述是在线(in‑line)学习。更先进的是离线优化平台——Agent Gym:

- 不在生产执行路径内,可使用任意 LM 与离线工具/云应用;

- 提供仿真环境,支持试错与压力测试;

- 调用合成数据生成器(含红队化、动态评估、批评智能体族);

- 工具库可扩展(通过 MCP / A2A 接入)并能学习新概念并造工具;

- 面对“部落知识”类边界问题,连接领域专家提供指导。

高级示例(第 47–50 页)

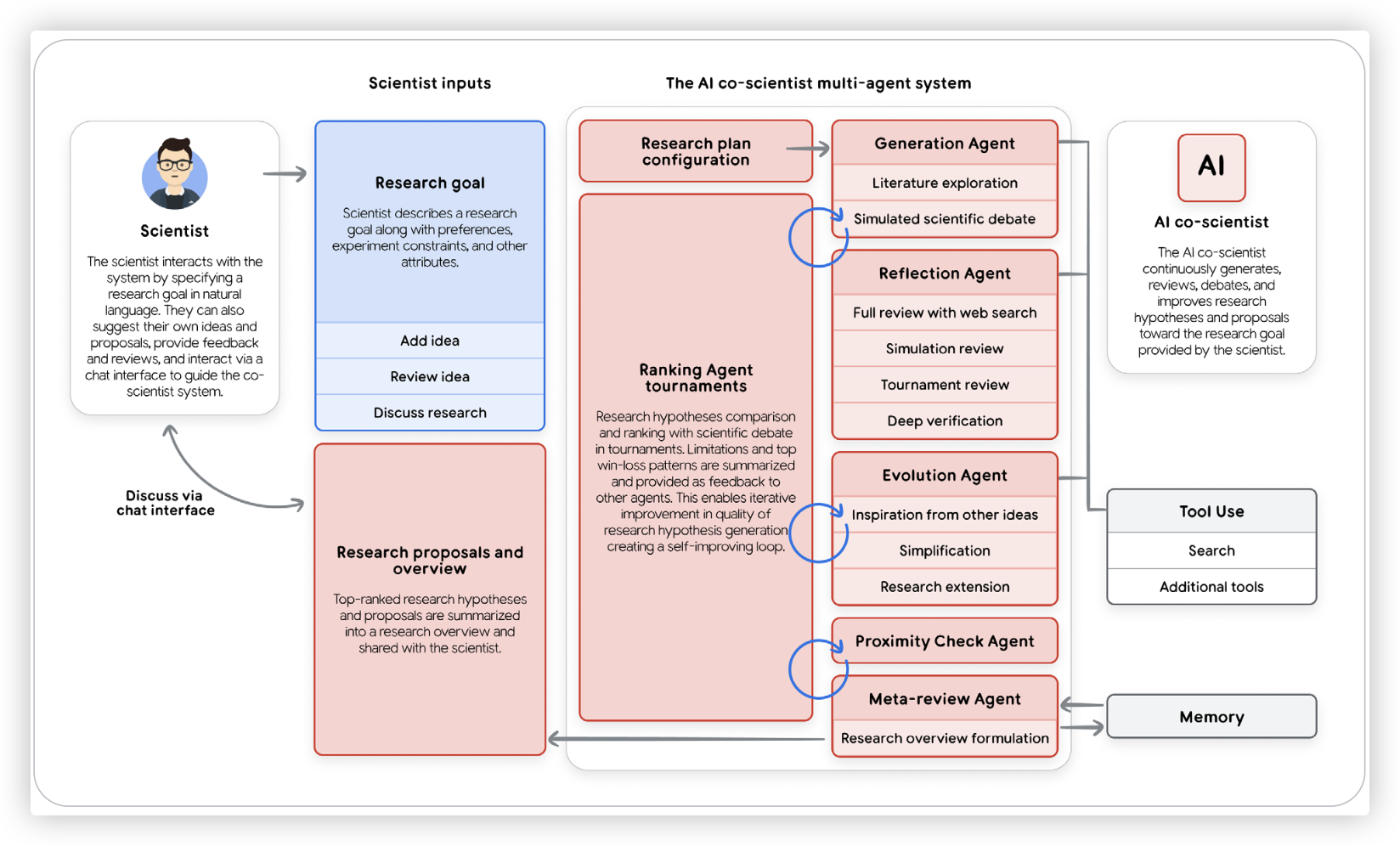

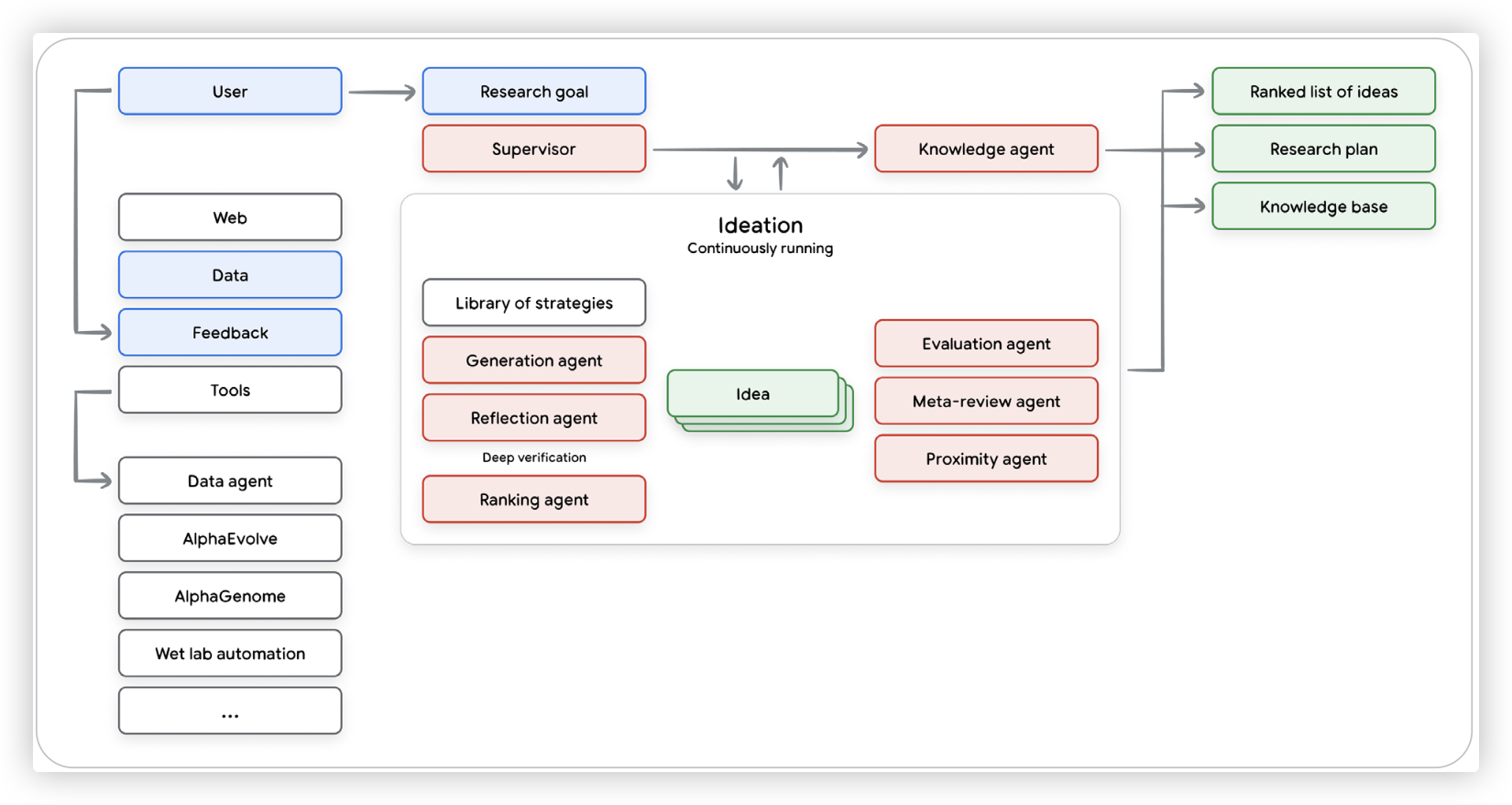

Google Co‑Scientist(第 47–48 页)

作为虚拟科研合作者,Co‑Scientist 能系统性地探索问题空间:研究者给定目标与知识源,系统生成并评估新假设版图,并孵化一组协作智能体完成任务。

- 先将研究目标展开为项目计划;Supervisor 像项目经理一样分派任务给专精智能体并分配资源(算力等);

- 智能体可长时间运行(数小时/天),在生成与评审的元循环中改进想法与评价方法。

**图 8(第 47 页)与图 9(第 48 页)**给出了系统与流程示意。

**图 8(第 47 页)与图 9(第 48 页)**给出了系统与流程示意。

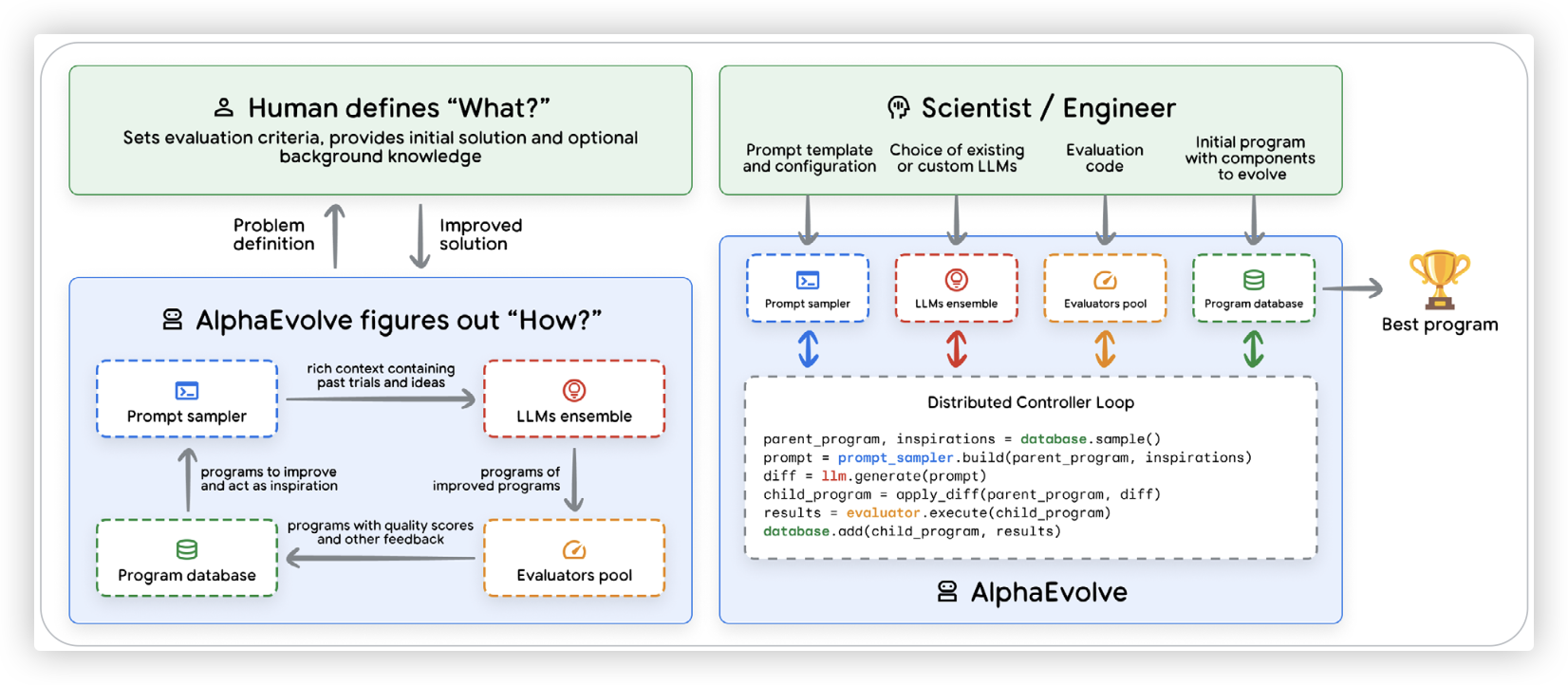

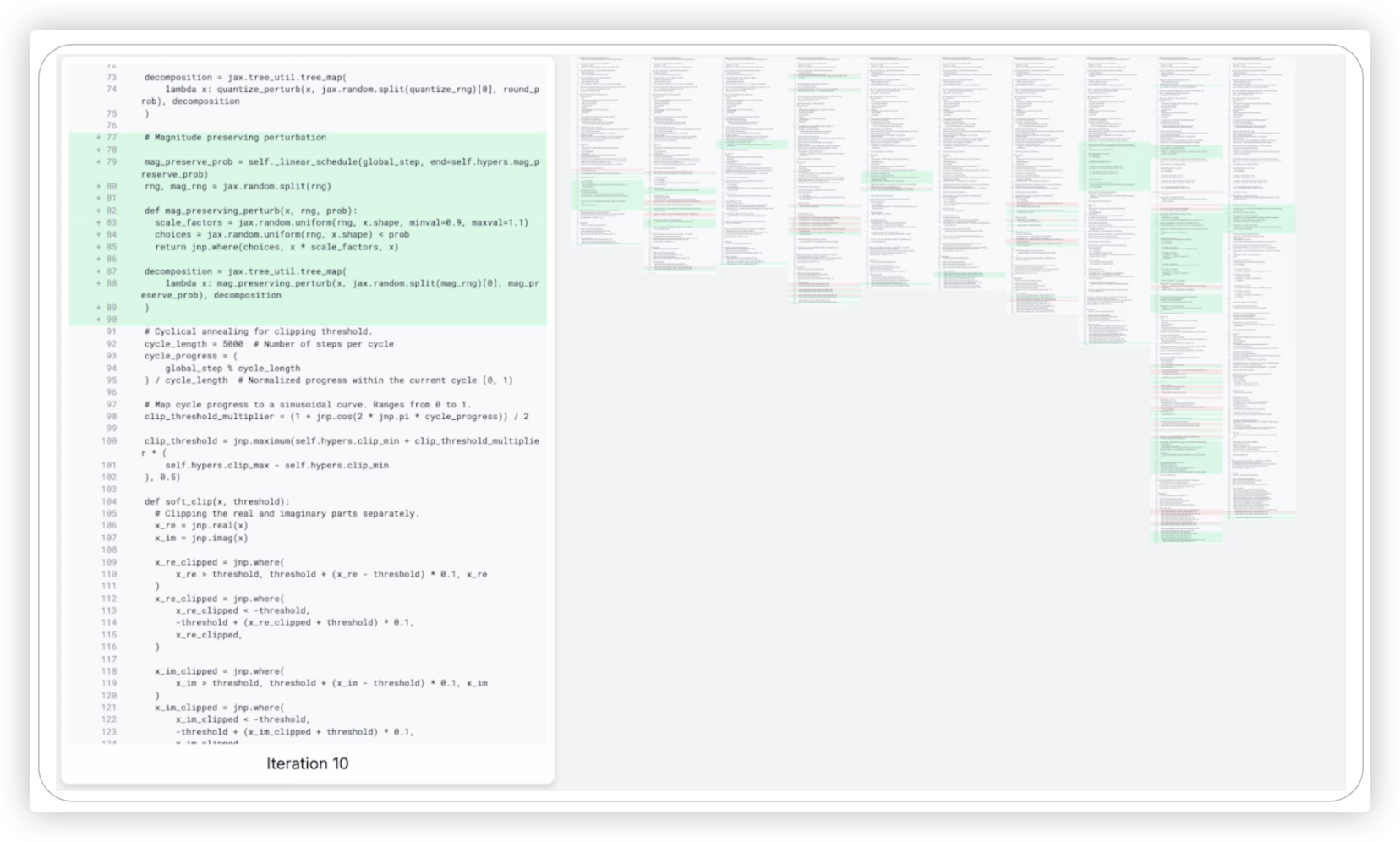

AlphaEvolve Agent(第 49–50 页)

AlphaEvolve 面向数理与计算机科学中的复杂算法问题,将 Gemini 的创造性代码生成与自动评估系统结合,以进化式流程循环:生成→评分→优胜继承。

成果示例:

- 提升 Google 数据中心、芯片设计与 AI 训练的效率;

- 发现更快的矩阵乘法算法;

- 为未解数学问题找到新思路。

特点:验证容易但搜索困难的问题更适合;输出为人类可读代码,透明可修改;专家通过优化评价指标与探索边界引导系统,避免“钻规则空子”。**图 10/11(第 49–50 页)**展示了设计系统与算法进化示意。

特点:验证容易但搜索困难的问题更适合;输出为人类可读代码,透明可修改;专家通过优化评价指标与探索边界引导系统,避免“钻规则空子”。**图 10/11(第 49–50 页)**展示了设计系统与算法进化示意。

结论(第 51 页)

生成式 AI 智能体把 AI 从被动内容工具转向主动的自主问题求解伙伴。本文提供了从原型走向生产级的架构化蓝图:

- 把智能体拆解为Model(大脑)、Tools(双手)与Orchestration Layer(神经系统),在Think–Act–Observe循环中释放能力;

- 用分级分类为架构与产品决策定界;

- 开发者角色从“砌砖工”转为“架构师/导演”,成功关键不止在 prompt,而在工具契约、错误处理、上下文管理与全面评估;

- 以工程化纪律构建协作、能干、可适应的新团队成员。

注释与参考(第 52–54 页,原样译出,链接保留)

- Julia Wiesinger, Patrick Marlow, 等(2024)“Agents”。可见:https://www.kaggle.com/whitepaper-agents

- Antonio Gulli, Lavi Nigam, 等(2025)“Agents Companion”。可见:https://www.kaggle.com/whitepaper-agent-companion

- Shunyu Yao 等(2022)“ReAct: Synergizing Reasoning and Acting in Language Models”。https://arxiv.org/abs/2210.03629

- Wei, J., Wang, X. 等(2023)“Chain-of-Thought Prompting Elicits Reasoning in Large Language Models”。https://arxiv.org/pdf/2201.11903.pdf

- 同注 3。

- https://www.amazon.com/Agentic-Design-Patterns-Hands-Intelligent/dp/3032014018

- Shunyu Yao 等(2024)“τ‑bench: A Benchmark for Tool‑Agent‑User Interaction in Real‑World Domains”。https://arxiv.org/abs/2406.12045

- https://artificialanalysis.ai/guide

- https://cloud.google.com/vertex-ai/generative-ai/docs/model-reference/vertex-ai-model-optimizer

- https://gemini.google/overview/gemini-live/

- https://cloud.google.com/vision

- https://cloud.google.com/speech-to-text

- https://medium.com/google-cloud/genaiops-operationalize-generative-ai-a-practical-guide-d5bedaa59d78

- https://cloud.google.com/vertex-ai/generative-ai/docs/agent-engine/code-execution/overview

- https://ai.google.dev/gemini-api/docs/function-calling

- https://github.com/modelcontextprotocol/

- https://ai.google.dev/gemini-api/docs/google-search

- https://google.github.io/adk-docs/

- https://google.github.io/adk-docs/sessions/memory/

- https://cloud.google.com/architecture/choose-design-pattern-agentic-ai-system

- https://cloud.google.com/vertex-ai/generative-ai/docs/agent-engine/overview

- https://cloud.google.com/kubernetes-engine/docs/concepts/gke-and-cloud-run

- https://github.com/GoogleCloudPlatform/agent-starter-pack

- Sokratis Kartakis(2024)“GenAI in Production: MLOps or GenAIOps?” https://medium.com/google-cloud/genai-in-production-mlops-or-genaiops-25691c9becd0

- Guangya Liu, Sujay Solomon(2025.3)“AI Agent Observability – Evolving Standards and Best Practice”。https://opentelemetry.io/blog/2025/ai-agent-observability/

- https://discuss.google.dev/t/agents-are-not-tools/192812

- Damien Masson 等(2024)“DirectGPT: A Direct Manipulation Interface to Interact with Large Language Models”。https://arxiv.org/abs/2310.03691

- MCP UI:https://mcpui.dev/

- AG UI:https://ag-ui.com/

- A2UI:https://github.com/google/A2UI

- https://cloud.google.com/vertex-ai/generative-ai/docs/models/gemini/2-5-flash-live-api

- https://saif.google/focus-on-agents

- https://simonwillison.net/series/prompt-injection/

- https://storage.googleapis.com/gweb-research2023-media/pubtools/1018686.pdf

- https://spiffe.io/

- https://openreview.net/pdf?id=l9rATNBB8Y

- https://google.github.io/adk-docs/safety/

- https://google.github.io/adk-docs/callbacks/design-patterns-and-best-practices/#guardrails-policy-enforcement

- TKTK

- https://cloud.google.com/security-command-center/docs/model-armor-overview

- https://cloud.google.com/vertex-ai/generative-ai/docs/provisioned-throughput/overview

- https://cloud.google.com/run/sla

- https://github.com/CharlesQ9/Self-Evolving-Agents

- Juraj Gottweis 等(2025)“Accelerating scientific breakthroughs with an AI co‑scientist”。https://research.google/blog/accelerating-scientific-breakthroughs-with-an-ai-co-scientist/

- Deepak Nathani 等(2025)“MLGym: A New Framework and Benchmark for Advancing AI Research Agents”。https://arxiv.org/abs/2502.14499

译注与说明

- 为确保技术一致性与可检索性,文中关键术语采用中英并列或英文保留(如 Agent Ops, RAG, Orchestration Layer, ADK, MCP, A2A, HITL, OpenTelemetry, Provisioned Throughput)。

- 图示(“图 X,第 Y 页”)为原文图片/示意图对应位置的说明,供读者在原 PDF 中对照查阅。

- 本译文忠实于原文结构与措辞;如需术语表或双语对照版(中英并排),我可以在此基础上生成。

全文来源:《Introduction to Agents》PDF(共 54 页)。